语音合成(TTS)技术正逐步渗透至智能设备、教育、客服等领域,其核心目标是将文本转化为自然流畅的语音。本文将从环境搭建、参数调优到实战应用,系统解析高效语音合成的关键技巧,助您掌握从入门到精通的完整路径。

一、环境配置与工具选择

1. 跨平台工具安装指南

Python/Linux环境:通过`virtualenv`创建隔离环境,安装`gTTS`、`pyttsx3`等库实现快速语音合成(示例代码见)。

Android集成:调用系统内置`TextToSpeech`引擎,需在代码中初始化TTS对象并配置语言参数(参考)。

云端服务部署:阿里云、腾讯云等平台提供API服务,通过SDK调用实现高并发场景下的语音生成(操作步骤见)。

2. 版本选择的黄金法则

开发阶段:优先选择社区活跃的开源库(如`edge-tts`),便于调试和功能扩展。

生产环境:推荐企业级服务(如阿里云TTS),保障稳定性与多语言支持。

3. 安全注意事项

API密钥保护:避免硬编码密钥,使用环境变量或密钥管理服务(如AWS KMS)。

本地数据加密:合成语音文件需存储时,采用AES-256加密防止敏感信息泄露。

二、核心技术解析与参数调优

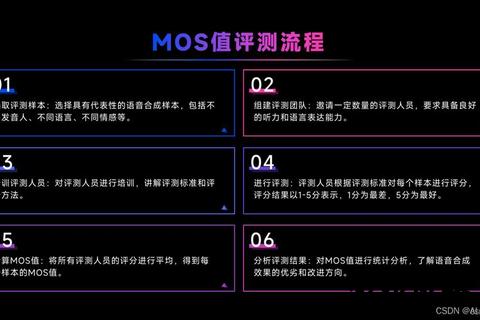

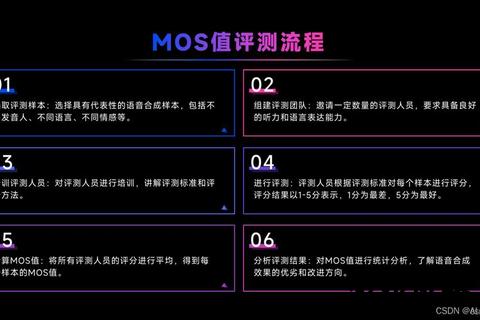

1. 语音合成的核心流程

文本预处理:分词、多音字消歧、韵律标注(技术原理参考)。

声学模型优化:通过`WaveNet`或`Tacotron`生成频谱参数,调整基频和共振峰提升自然度。

波形生成:使用声码器(如`HiFi-GAN`)将声学特征转化为48kHz高保真音频。

2. 参数调优实战技巧

语速与语调:在`gTTS`中设置`slow=False`加快语速,结合`pitch`参数调整情感表达。

多角色切换:通过`voice`参数指定不同发音人(如微软的`zh-CN-YunxiNeural`),适应旁白、对话等场景。

三、实战技巧与高阶应用

1. 教育场景的语音助手开发

代码示例:调用API生成课程音频并保存为MP3,支持离线播放(Python实现见)。

长文本优化:采用分句合成与动态拼接技术,避免单次请求超限(参考)。

2. 导航语音包定制

个性化声纹:基于少量录音样本训练专属声学模型(如高德地图明星语音包技术)。

实时语音播报:结合GPS定位动态生成导航指令,延迟需控制在200ms以内。

3. 工业级部署方案

容器化部署:通过Docker封装`edge-tts`服务,支持快速扩展至多节点。

性能监控:使用Prometheus+Granafa监控API响应时间与错误率,保障服务可用性。

四、用户评价与行业反馈

1. 正面评价

效率提升:开发者反馈,调用云端API可将开发周期缩短60%以上。

拟真度突破:用户认为优化后的模型(如豆包语音)已接近真人90%的表现。

2. 现存挑战

长文本连贯性:部分开源库在合成超500字文本时易出现断句异常。

小语种支持不足:除中英文外,方言与稀有语种的发音准确率仍需提升。

五、未来趋势与技术展望

1. 情感化交互升级

情感识别融合:通过NLP分析文本情绪,动态调整语音的抑扬顿挫(技术路径见)。

多模态输出:结合AR/VR设备实现3D空间音频定位(实验性应用已见于车载导航)。

2. 轻量化与实时化

端侧推理:基于TensorFlow Lite的移动端TTS模型,延迟可压缩至50ms以内。

无监督学习:利用对比学习减少对标注数据的依赖,加速新语种模型训练。

3. 与合规

声纹盗用防范:需建立声纹指纹库,防止AI合成语音用于欺诈(行业倡议见)。

TTS技术的突破不仅在于算法优化,更在于与场景的深度结合。开发者需平衡性能、成本与用户体验,而用户则应关注隐私保护与技术边界。随着AI技术的持续迭代,语音合成将逐步跨越“机械感”鸿沟,成为人机交互的核心纽带。